GoogleがAIに力を入れていることは有名ですよね!

Google I/O 2019では今までサーバーを通して行ってきたGoogleアシスタントの処理をスタンドアローンで行えるようにできた発表されました。

なぜ出来たかというと今までは認識や解析モデルに100GB以上のデータが必要だったものをノウハウの積み重ねで0.5GB以下にまでモデルサイズを縮小しそのおかげで端末だけでもGoogleアシスタントのAI処理を行えるようになったとのこと。

実際にデモでは高速でアプリの切り替わりが行われているので開発力が恐ろしい…

ただ、クラウド重視のGoogleが端末で完結してしまう方向性の技術を発表し実装っしている点に今までとは違う思惑を感じますね。

また、最大の不安点は現時点で特定の端末のサポートを明言してないことでスタンドアローンで動くことを考えるとスペックの要求があるはずなのでPixel 3などのGoogle端末や秋冬に登場すると噂されるPixel4専用なのか発表はされておりません。

クラウド志向のGoogleがスタンドアローンに回帰する動きということはもしやPixelシリーズを売るためだけのサービスも可能性も考えてしましますね。

実際レスポンスが速くなること以外は今までのGoogleアシスタントでも可能なので不安な部分が残ります。

理想的にはAndroid 10以降すべての端末でも使えるような制限であると嬉しいですね。

その他にもGoogle I/O 2018で話題となったAIによる自然な会話でお店の予約が可能なDuplexがWEB予約に対応したり、Googleレンズを向けることでレストランなどのメニューから料理類似の料理を表示してくれる機能、Googleサーチで検索した物や動物などをARで表示してくれる機能など凄まじい進化を遂げています。

かなり残念なのはこれらの機能が日本語も対応されるのか不明なところで特にDuplexに関しては昨年の発表にも関わらず現時点でも日本語に対応する噂も殆どありません。

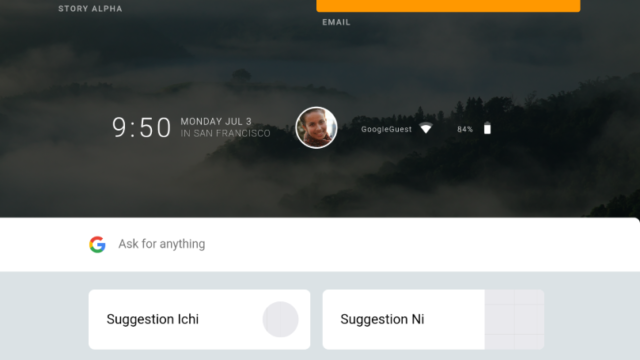

日本での対応でも期待ができそうなのがGoogleアシスタントの[ドライブモード]運転時に最適化されたUIでの表示が可能で一つ一つのボタンが大きく表示されています。

こんな感じ↓

Source:Google

Source:Google運転することがそんなにないのですが、タブレットでこの使い方はマップと連携して使うと便利そうです。

Googleアシスタントに関しては他社の追随を許さないレベルでAIの強化が毎年図られていますが残念ながら日本で使えないサービスも多く言語の壁を思い知らされれますね。

近い将来に対応することを期待してGoogleアシスタントについては終わります。

![悲しい事実…[Digital Wellbeing]を無効にするとパフォーマンスが向上にするという](https://ga-dget-hack.com/wp-content/uploads/2019/05/Digital-Wellbeing-640x360.png)

![悲しい事実…[Digital Wellbeing]を無効にするとパフォーマンスが向上にするという](https://ga-dget-hack.com/wp-content/uploads/2019/05/Digital-Wellbeing-320x180.png)